监督学习(利用标号信息)的本质就是规则化参数的同时最小化误差(minimize error while regularizing parameters)。最小化误差是为了让我们的模型拟合我们的训练数据,而规则化参数是防止我们的模型过分拟合我们的训练数据。

因为参数太多,会导致我们的模型复杂度上升,容易过拟合,也就是我们的训练误差会很小。但训练误差小并不是我们的最终目标,我们的目标是希望模型的测试误差小,也就是能准确的预测新的样本。所以,我们需要保证模型“简单”的基础上最小化训练误差,这样得到的参数才具有好的泛化性能(也就是测试误差也小),而模型“简单”就是通过规则函数来实现的。规则项的使用还可以约束我们的模型的特性。这样就可以将人对这个模型的先验知识融入到模型的学习当中,强行地让学习到的模型具有人想要的特性,例如稀疏、低秩、平滑等等。从贝叶斯估计的角度来看,规则化项对应于模型的先验概率。民间还有个说法就是,规则化是结构风险最小化策略的实现,是在经验风险上加一个正则化项(regularizer)或惩罚项(penalty term)。

1、范数与优化问题

范数: 向量各个元素绝对值最大那个元素的绝对值,

范数: 向量各个元素绝对值最大那个元素的绝对值,

范数:向量各个元素绝对值之和

范数:向量各个元素绝对值之和

范数:向量中非0的元素的个数

范数:向量中非0的元素的个数

首先让我们看一个优化问题,![D=[d_{1},...,d_{p}]](http://ramsey16.net/wp-content/plugins/latex/cache/tex_1ad84b50ff8f968f82e6e83a861c3003.gif) 为一组基列向量(对应于人脸识别问题,可以是不同人脸同一位置的图像块组成的像素值形成的列向量),对于一个输入列向量

为一组基列向量(对应于人脸识别问题,可以是不同人脸同一位置的图像块组成的像素值形成的列向量),对于一个输入列向量 (输入人脸这一位置的图像块),通过寻找一个稀疏向量

(输入人脸这一位置的图像块),通过寻找一个稀疏向量 使得

使得 为这些基向量的稀疏线性组合,表达如下:

为这些基向量的稀疏线性组合,表达如下:

1)

1)

当![D=[d_{1},...,d_{p}]](http://ramsey16.net/wp-content/plugins/latex/cache/tex_1ad84b50ff8f968f82e6e83a861c3003.gif) 为一组正交小波基即

为一组正交小波基即 ,式1)等价于

,式1)等价于

定义向量

,所以

,所以 因为

因为 是一个正交阵。为了获得最佳的稀疏近似,取

是一个正交阵。为了获得最佳的稀疏近似,取 个最大的系数

个最大的系数![\{\lvert \beta[1]\rvert,...,\lvert \beta[p]\rvert\}](http://ramsey16.net/wp-content/plugins/latex/cache/tex_503f287d053b8903a5e4f7b1b228d0dc.gif) 的值。

的值。

但是1)L0范数很难优化求解(NP难问题),2)L1范数是L0范数的最优凸近似,而且它比L0范数要容易优化求解。上述问题转化为:

2)

2)

这个也就是著名的LASSO。 范数保证解的稀疏性,参数

范数保证解的稀疏性,参数 控制数据拟合与稀疏度间的tradeoff。实际上,减小

控制数据拟合与稀疏度间的tradeoff。实际上,减小 值大小会导致解更为稀疏即有更多零项。

值大小会导致解更为稀疏即有更多零项。

- Basis Pusuit:

3)

3)

在这里, 范数作为惩罚项而非约束项。

范数作为惩罚项而非约束项。

Fig.1 Two examples of regularization paths for the Lasso/Basis Pursuit

如图,当 ,solution is dense;而增大

,solution is dense;而增大 ,越来越多的变量被置0,但是

,越来越多的变量被置0,但是 与解的稀疏度间并不一定是单调关系。有些情况下增大

与解的稀疏度间并不一定是单调关系。有些情况下增大 会产生一个denser solution。

会产生一个denser solution。

这里如果我们采用重构误差作为约束条件来寻求一个稀疏重构系数,表达形式如下:

4)

4)

这种表达形式非常有用,如果我们对误差分布有先验知识,参数 较为容易选择。对于无噪声的问题(noiseless),上式改写如下:

较为容易选择。对于无噪声的问题(noiseless),上式改写如下:

5)

5)

式3)的解集收敛于式5)的解当 趋于

趋于 时。

时。

这里损失函数并不定义是在最小二乘(平方)意义下,如下:

6)

6)

where  为损失函数。

为损失函数。

说了这么多,我们还是想知道 范数为什么会导致稀疏性,

范数为什么会导致稀疏性, 范数的稀疏性显而易见。

范数的稀疏性显而易见。

首先引出一个说法:任何的规则化算子,如果他在Wi=0的地方不可微,并且可以分解为一个“求和”的形式,那么这个规则化算子就可以实现稀疏。这说是这么说, 的

的 范数是绝对值,|w|在w=0处是不可微,但这还是不够直观。

范数是绝对值,|w|在w=0处是不可微,但这还是不够直观。

2、 范数的稀疏性

范数的稀疏性

临界点角度分析

对于正交阵 ,

, 分解问题可以通过"soft-thresholding"保证封闭形式的解析解。

分解问题可以通过"soft-thresholding"保证封闭形式的解析解。

对于 内积小于

内积小于 ,其对应的

,其对应的![\alpha^{*}[i]](http://ramsey16.net/wp-content/plugins/latex/cache/tex_62faef0cc96317d4f01c124ba7d8e4ed.gif) 等于0。所以解

等于0。所以解 的零项随着

的零项随着 单调递增。

单调递增。

对于非正交阵 ,这种单调关系并不一定保证。但是实际中,

,这种单调关系并不一定保证。但是实际中, 范数的稀疏性仍旧有效。对于泛化的

范数的稀疏性仍旧有效。对于泛化的 正则化问题进一步了解,

正则化问题进一步了解, ,

, 可微,有以下定理:

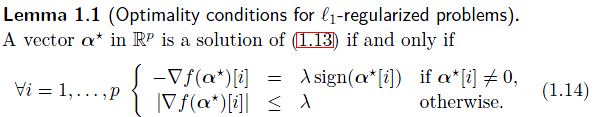

可微,有以下定理:

当 时,该最优性条件满足对于

时,该最优性条件满足对于 ,所以可以得到最稀疏的解。

,所以可以得到最稀疏的解。

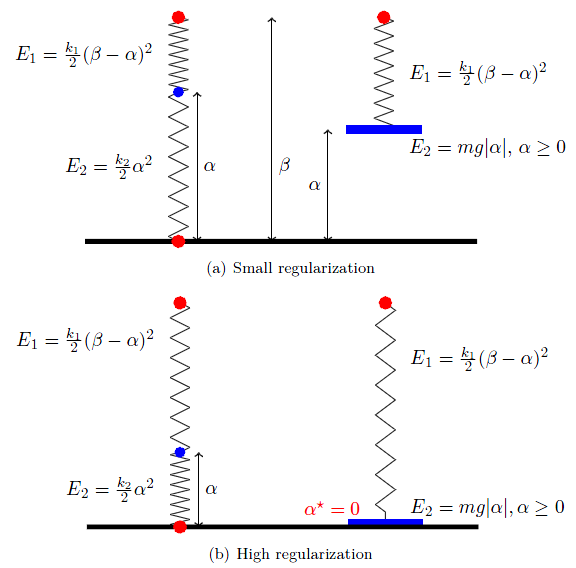

物理意义分析

在图像处理或计算机视觉领域,能量代表着一个最小化问题的目标函数。负的能量梯度代表着一种趋势。考虑一维 正则化问题

正则化问题

7)

7)

从能量最小化的角度出发, 惩罚项可以看作为驱动

惩罚项可以看作为驱动 以常值

以常值 朝

朝 前进。

前进。

利用平方 惩罚项或者岭回归惩罚项代替,表达如下:

惩罚项或者岭回归惩罚项代替,表达如下:

8)

8)

二次能量 的微分为

的微分为 ,

, 惩罚项可以看作为驱动

惩罚项可以看作为驱动 以

以 朝

朝 前进。

前进。

所以 惩罚项最大的劣势就在于当

惩罚项最大的劣势就在于当 时,相对应的force就很小,从而无法保证稀疏性。

时,相对应的force就很小,从而无法保证稀疏性。

从解析角度,式7)的解为0当 时。而式8保证闭集解

时。而式8保证闭集解 。显然,这个解永远不会为0。

。显然,这个解永远不会为0。

弹簧的弹性势能为二阶形式,而重力势能在地球表面近似线形。

几何形式分析

norm 可以理解为

norm 可以理解为 -ball

-ball

where

where  。如果D为非正交阵,经典解法为projected gradient method。

。如果D为非正交阵,经典解法为projected gradient method。